读取大脑重建高清视频,StableDiffusion还能这么用

来源:IT之家 发布时间:2023-05-25 11:56 关键词:视频,io 阅读量:9289

现在,AI 可以把人类脑中的信息,用高清视频展示出来了!

例如你坐在副驾所欣赏到的沿途美景信息,AI 分分钟给重建了出来:

看到过的水中的鱼儿、草原上的马儿,也不在话下:

这就是由新加坡国立大学和香港中文大学共同完成的最新研究,团队将项目取名为 MinD-Video。

这波操作,宛如科幻电影《超体》中 Lucy 读取反派大佬记忆一般:

引得网友直呼:

推动人工智能和神经科学的前沿。

值得一提的是,大火的 Stable Diffusion 也在这次研究中立了不小的功劳。

怎么做到的?

从大脑活动中重建人类视觉任务,尤其是功能磁共振成像技术这种非侵入式方法,一直是受到学界较多的关注。

因为类似这样的研究,有利于理解我们的认知过程。

但以往的研究都主要聚焦在重建静态图像,而以高清视频形式来展现的工作还是较为有限。

而 fMRI 这项技术的本质是测量血氧水平依赖信号,并且在每隔几秒钟的时间里捕捉大脑活动的快照。

相比之下,一个典型的视频每秒大约包含 30 帧画面,如果要用 fMRI 去重建一个 2 秒的视频,就需要呈现起码 60 帧。

因此,这项任务的难点就在于解码 fMRI 并以远高于 fMRI 时间分辨率的 FPS 恢复视频。

为了弥合图像和视频大脑解码之间差距,研究团队便提出了 MinD-Video 的方法。

整体来看,这个方法主要包含两大模块,它们分别做训练,然后再在一起做微调。

这个模型从大脑信号中逐步学习,在第一个模块多个阶段的过程,可以获得对语义空间的更深入理解。

具体而言,便是先利用大规模无监督学习与 mask brain modeling来学习一般的视觉 fMRI 特征。

然后,团队使用标注数据集的多模态提取语义相关特征,在对比语言-图像预训练空间中使用对比学习训练 fMRI 编码器。

在第二个模块中,团队通过与增强版 Stable Diffusion 模型的共同训练来微调学习到的特征,这个模型是专门为 fMRI 技术下的视频生成量身定制的。

而且在场景连续变化的过程中,也能够呈现高清、有意义的连续帧。

研究团队

这项研究的共同一作,其中一位是来自新加坡国立大学的博士生 Zijiao Chen,目前在该校的神经精神疾病多模式神经成像实验室。

另一位一作则是来自香港中文大学的 Jiaxin Qing,就读专业是信息工程系。

除此之外,通讯作者是新加坡国立大学副教授 Juan Helen ZHOU。

据了解,这次的新研究是他们团队在此前一项名为 MinD-Vis 的功能磁共振成像图像重建工作的延伸。

MinD-Vis 已经被 CVPR 2023 所接收。

参考链接:

郑重声明:此文内容为本网站转载企业宣传资讯,目的在于传播更多信息,与本站立场无关。仅供读者参考,并请自行核实相关内容。

站点精选

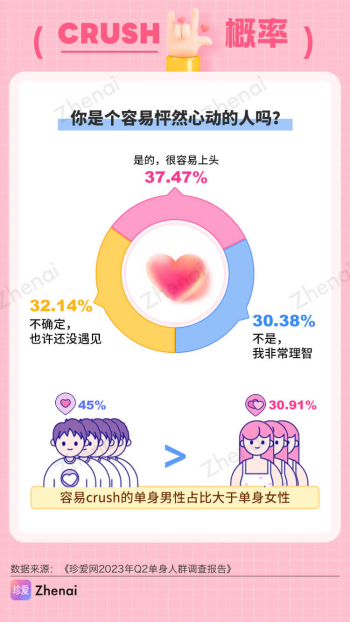

据民政部公布的数据显示,从2013年到2021年,结婚登记对数逐年下降,恐婚、懒婚、不婚等成为了当下青年的群体特征,但“地铁上那只好看的手”、“发丝拂过你脸庞”...

- OPPOReno10Pro+灿烂金图赏:把金色玩得清新脱俗2023-05-24

- 倡导食用油“精准适度加工”实现“降油增绿”2023-05-24

- Netflix港台区付费共享账户方案公布,每人每月额外付282023-05-24

- 市场人士:英伟达AIGPU需求量飙升,代工厂台积电已开足马力2023-05-24

- CHERRYx传奇世界推出20周年联名定制款机械键盘:MX32023-05-24